Если на сайте много страниц, не факт, что бот их проиндексирует все — он может проиндексировать ошибочные, а на важные не хватит времени и бюджета. Индексация страниц сайта сейчас происходит в самые короткие сроки. При правильной настройке документы могут попадать в индекс поиска уже через полчаса после размещения. В некоторых случаях может потребоваться не проиндексировать, а наоборот запретить индексацию. К примеру, вы только создаете страницу и на ней нет нужной информации, или вообще сайт в разработке и все страницы — тестовые и недоработанные.

- Рекомендуем обращать внимание не только на те страницы, что попали в индекс, но и на те, что не попали.

- Уникальный тариф «Оборот», где доход агентства больше не зависит от визитов и позиций вашего сайта, а привязан исключительно к росту оборота вашей компании.

- Заставить Google переиндексировать столь значительный объем страниц в короткий срок не получиться, все упирается в краулинговый бюджет сайта.

- Пока информация о новой странице не окажется в базе, ее не будут показывать по запросам пользователей.

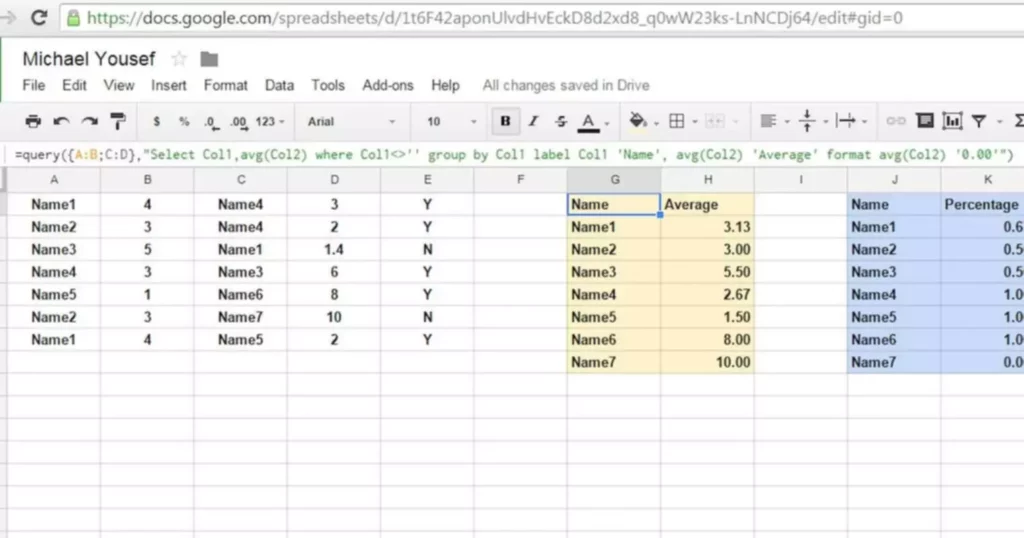

Есть ряд способов, чтобы увеличить количество страниц, которые сумеет обойти краулер за одно посещение. Большая их часть направлена в основном на улучшение технического состояния и поведенческих факторов. Это именно то, на что стоит обратить внимание в первую очередь. Для анализа можно использовать ПО для настольного краулинговый бюджет компьютера, например, GamutLogViewer или Screaming Frog Log File Analyser (условно-бесплатный), либо внешние сервисы типа splunk.com. Но внешние сервисы обычно рассчитаны на большие объёмы данных, и стоят дорого. Выберите соцсеть, которую роботы хорошо сканируют и постоянно мониторят, и закиньте туда ссылочку.

Javascript Web Optimization: 4 Проблемы, Которые Мешают Вам Получать Трафик

Однако не нужно думать, что робот обязательно учтет ваши указания. Фактически вы можете рассчитывать только на то, что робот увидит ваш список URL для обхода и рано или поздно воспользуется им. Всё остальное, как правило, игнорируется во избежание манипуляций. Однако это вовсе не значит, что этих директив быть не должно.

Если там все в порядке, проверяем, нет ли фильтров, и в последнюю очередь обращаемся к администратору хостинга. Тут вы увидите, какие документы оказались вне поискового индекса. Разберем несколько примеров закрытия страниц от индексирования. Большая часть CMS позволяют использовать этот метод в один клик, предлагая готовые решения. У WordPress, например, для этого имеется отдельная строчка в настройках редактора, а в «1С-Битрикс» путем настроек раздела и конкретной страницы.

У меня был случай, когда клиент при самостоятельном обновлении плагинов как-то внес изменения в файл robots.txt, и сайт исчез из поисковой выдачи. Поэтому при всех действиях, которые связаны с этим файлом, обязательно проверяйте, нет ли изменений в директивах. Под индексацией понимают добавление информации о сайте или странице в базу данных поисковой системы. Фактически поисковую базу можно сравнить с библиотечным каталогом, куда внесены данные о книгах.

«кольцевые» Ссылки, «висячие Узлы» И Изолированные Страницы

В таком случае Canonical действует как мягкий 301-й редирект. Полезно сопоставить количество страниц в индексах Яндекс и Google. Правила обхода этих систем отличаются, но разница не должна быть существенной.

Поэтому в обязательном порядке нужно настраивать 301-й (постоянный) редирект на выбранную вами версию. Например, на нашем сайте количество страниц в индексации составило 150, количество обращений роботов — sixty seven. Краулеры поисковых систем воспринимают ваши страницы не так, как это делают люди, поэтому им необходима дополнительная помощь в понимании вашего контента. Бюджет сканирования веб-сайта – количество URL-адресов, которые бот поисковой системы может просканировать.

Однако внедрение поддержки этих протоколов, скорее всего, потребует дополнительной разработки на стороне вашего сайта. Проще всего узнать, с какой скоростью и как часто роботы обходят страницы, а документы попадают в индекс ПС, — обратиться к консолям Вебмастеров. К примеру, Я.Вебмастер демонстрирует графики и объёмы проиндексированных документов. Рассчитать скорость индексации и краулинговый бюджет с точностью не удастся, однако понимание того, каков максимум на сегодняшний день, появится. Материал пригодится тем, кто не представляет, что такое краулинговый бюджет сайта и как его рассчитать. То же самое касается ссылочного веса, передаваемого по внутренним ссылкам.

Вы можете использовать файл для блокировки тех страниц, которые вы считаете неважными и ненужными к индексированию. Также Google подтверждает наличие «краулингового бюджета» — регулярности и объема посещения сайта роботом. Чем больше краулинговый бюджет, тем быстрее новые страницы будут попадать в индекс. К сожалению, точных данных о способах расчета этого показателя представители компании не раскрывают.

Поисковые системы не стремяться сделать принципы ранжирования максимально прозрачными и понятными. Поэтому в таких вопросах приходится полагаться только на свои знания и интуицию. Различные специалисты называют принципиально отличные цифры, которые могут приводить к проблемам с краулинговыми бюджетами. Работа над индексом качества сайта включает в себя различные инструменты и методы. Они включают в себя комплекс действий по улучшению внешней и внутренней оптимизации сайта и работу над ссылочным профилем. Краулинговый бюджет – это специализированная метрика, отвечающая за формирование определённой квоты страниц хоста.

Как Управлять Сканированием И Индексацией?

Периодически проверяйте sitemap.xml – в ней не должно быть удаленных страниц, URL с перенаправлениями и ошибками. Чтобы избавиться от дублей окончательно, нужны более радикальные меры, чем директивы для ботов. Оптимально – оценить возможность удаления дублирующегося контента. Опытные профессионалы поискового продвижения не просто так высоко оцениваются работодателями и кадровыми агентствами. Глубокая настройка и отладка проекта не только приводит к резкому росту качества ресурса, но и позволяет сохранять положительный эффект на протяжении длительного времени.

Структуру сайта, на котором любая страница доступна не более, чем за four клика от главной, принято считать плоской. Глубокой называют архитектуру сайта с вложенностью от 5 кликов от главной страницы. Далеко не каждая CMS позволяет создавать карту сайта в соответствии с вашими планами, и туда может попасть много мусора. Хуже того, некоторые CMS вообще не умеют такие карты сайта создавать. В таких случаях используются сторонние плагины или даже ручная загрузка карты сайта, сформированной каким-то ПО или внешним сервисом.

То есть робот зайдет один раз на ошибочную страницу, ничего там не найдет, позже зайдет еще несколько раз в попытках обнаружить там контент. Все эти попытки в отчетах мы не увидим — зафиксируется только одно обращение робота, хотя по факту их может быть 4-5. Краулинговый бюджет, который мы узнаем благодаря информации из Google Search Console и Яндекс.Вебмастер, будет примерный. Это связано с тем, что указанные сервисы засчитывают обращение роботов за день к любым страницам один раз.

Чтобы узнать краулинговый бюджет при помощи Яндекс.Вебмастер, выбираем раздел «Индексирование» → «Статистика обхода». Сервис показывает количество обращений к сайту за текущий день, но не показывает общий показатель за желаемый период. В некоторых случаях могут индексироваться технические страницы. К примеру, на WordPress при размещении изображений в виде медиафайла поисковый робот может индексировать каждую картинку в качестве отдельной страницы. В таком случае делаем редирект с этой страницы на тот документ, где изображение будет выводиться.

Основным отличием является использование технологии Mobile-first. Она подразумевает первоочередное сканирование и индексацию мобильной версии сайта. Получается, что если ваша страница при показе на мобильных устройствах будет содержать недостаточно нужной информации или в целом проигрывать основной версии сайта по качеству. Это стандартный процесс индексации документов для поисковых систем. При этом у «Яндекса» и Google существуют небольшие отличия в технических моментах, про это мы расскажем дальше.

Сразу стоит оговориться, что точные алгоритмы индексирования — закрытая коммерческая информация. Различие между техническим SEO-аудитом и обычным аудитом обычно заключается в объеме проверяемых аспектов веб-сайта, а также в тщательности. Бывает так, что страницы не индексируются из-за того, что грузятся слишком медленно. Наиболее распространенная причина – некорректное, нестабильное функционирование сервера. Вполне возможно, стоит задуматься о переходе на альтернативный, более надежный.

Например, результаты сортировки или работы фильтра товаров. Плюс такого решения — передача сигналов ранжирования (например поведенческих метрик) на страницы без параметров, что очень важно для Яндекса. Анализируя страницы непосредственно в сервисах Яндекса и Google для веб мастеров — Яндекс.Вебмастере и Google Search Console. Рекомендуем обращать внимание не только на те страницы, что попали в индекс, но и на те, что не попали. Важно понять, должны ли эти страницы индексироваться и если должны, то по какой причине этого не происходит. Прежде чем касаться вопроса индексации, необходимо вспомнить о целях любой поисковой системы.

Яндекс выбросит «битую» страницу быстрее, но если причины проблемы не устранены, будет возвращать её в индекс и снова выбрасывать. Начинающим вебмастерам вообще не стоит задумываться о краулинговом бюджете. Ведь он становится проблемой только в том случае, когда необходимо анализировать и добавлять в индекс сразу большие объёмы страниц с полезной информацией. Если ваш сайт насчитывает менее ста статей, можете вообще не придавать значение этой метрике.

Чем быстрее документы попадут в индекс, тем быстрее их увидят пользователи. Конечно же, на лимит можно повлиять, но это процесс постепенный и требующий долгой системной работы. Данный алгоритм предполагает, что сначала роботы оценят мобильный вариант ресурса, так что его разработке нужно уделить максимум внимания, экономия скажется и на статусе основной версии. Второй момент – “краулинговый бюджет”, частота и длительность посещения сайта роботами. Самый простой метод управления индексацией — текстовый файл robots.txt в корневой папке сайта. Как мы уже отметили ранее, поисковые роботы всегда обращаются к содержимому файла для понимания, какие страницы доступны к добавлению в поисковый индекс, а какие нет.

Наличие HTTP-кодов ответа сервера, отличных от 200, может стать серьезной проблемой на пути сканирования и индексации сайта. Из схемы можно увидеть, что процесс сканирования и индексирования — это база для ранжирования любого сайта. Если возникают существенные проблемы на любом из указанных этапов, то можно забыть о высоких позициях, росте трафика и лидов.

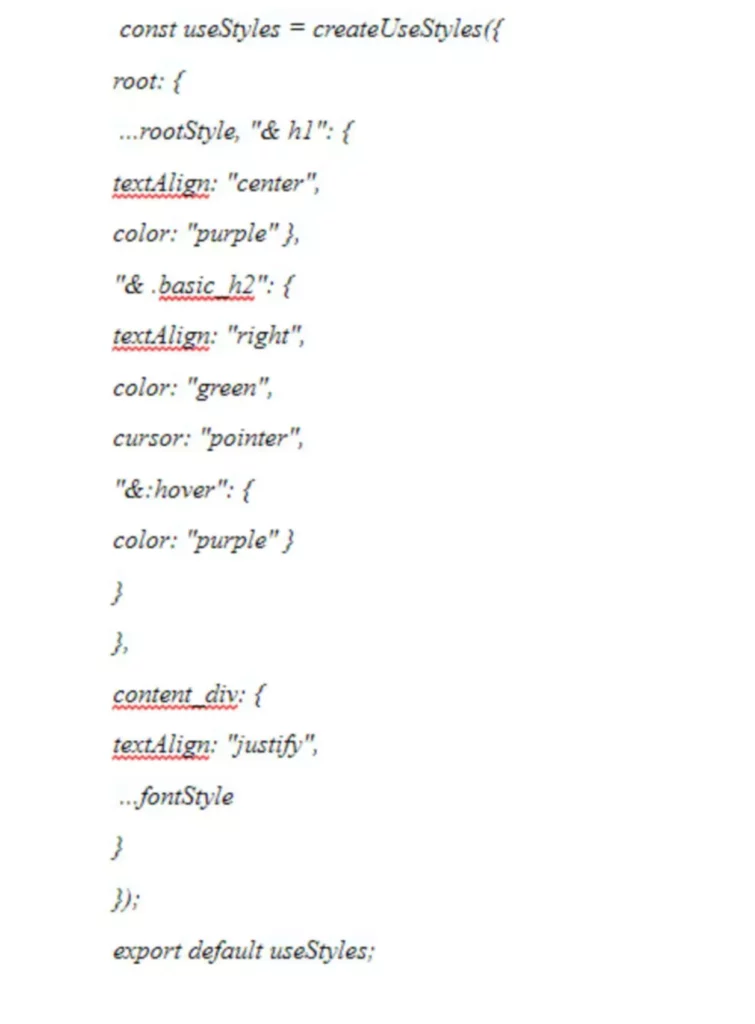

Это также может помочь вам оптимизировать время загрузки страницы и доступность. Неоптимизированный JavaScript может негативно сказаться на контенте, делая его невидимым для роботов поисковых систем и замедляя время обнаружения и загрузки страниц. Это еще одно препятствие на пути попадания ваших страниц в индекс. Сайт может как попасть в индекс, так и вылететь из него. Это значит, что ни один пользователь не увидит его в поисковой выдаче. А следовательно трафик на ресурс заметно снизится и потянет за собой количество клиентов.